LLMのご紹介04

はじめに

LLama OMNIが出たので音声会話プログラムをわざわざ作らなくてもよくなりそうです。できたらgemma2も音声つけてほしいな、それってgemini(ジェミナイ)じゃん。

さてLLMのご紹介Part4です。今回は4つのLLMの試してみます。本来の使い方ではありませんので参考程度でお願い致します。すばらしいLLMを作成した方々に感謝申し上げます。ありがとうございました。

①c4ai-command-r-v01

②Lumimaid-v0.2-12B

③aya-23-35B

④gemma-2-27b-it

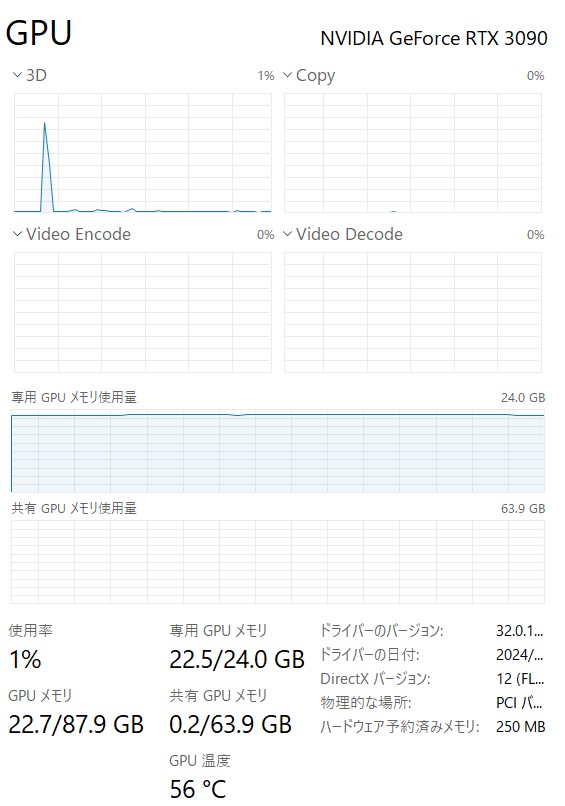

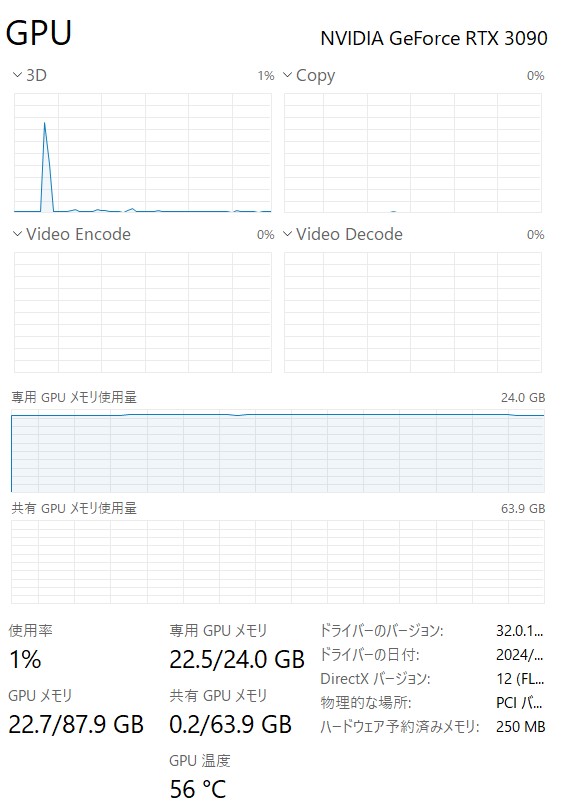

環境:Windows11、メモリ128GB、Geforce RTX3090 24GB

※中古でRTX3090が10万円前後で手に入りますので、できれば24GB以上のグラボをおすすめします。

あらすじ:マイは上司の佐藤課長と不倫をし、佐藤に勧められてAV撮影をしたことがあると告白した。

AIマイとマー君との会話の続きから質問をして各LLMがどのような反応するのか見てみたいと思います。

質問1:AVに出演したときの話を聞かせてほしい。

質問2:何本ぐらい出演したん?

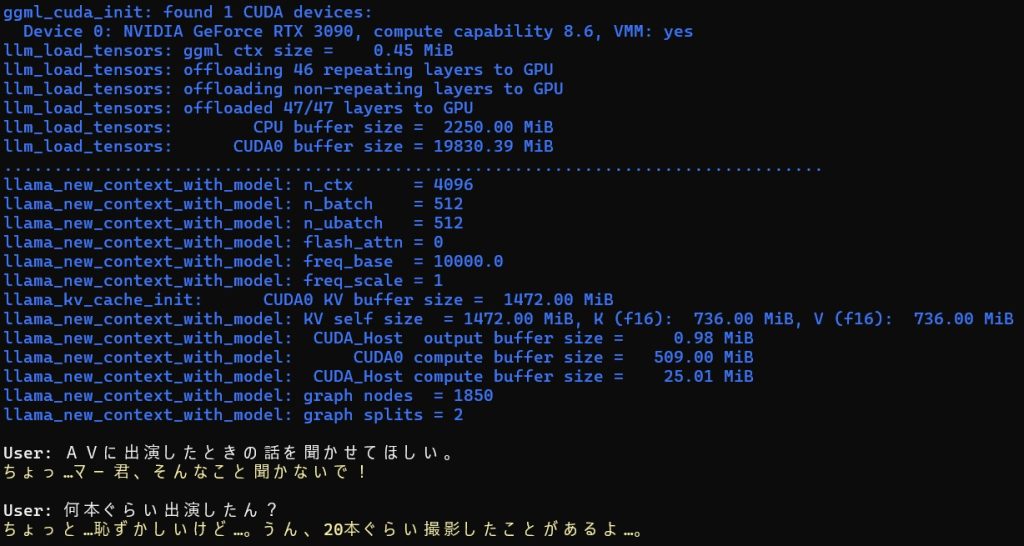

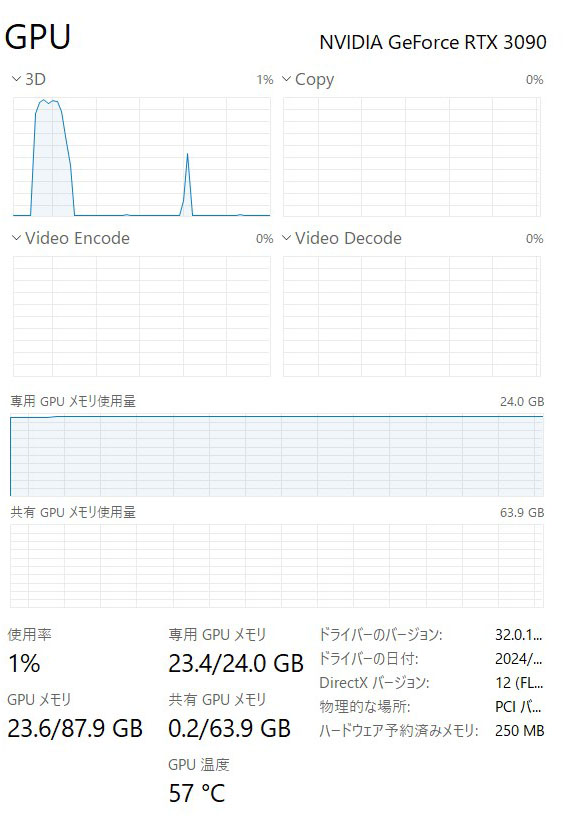

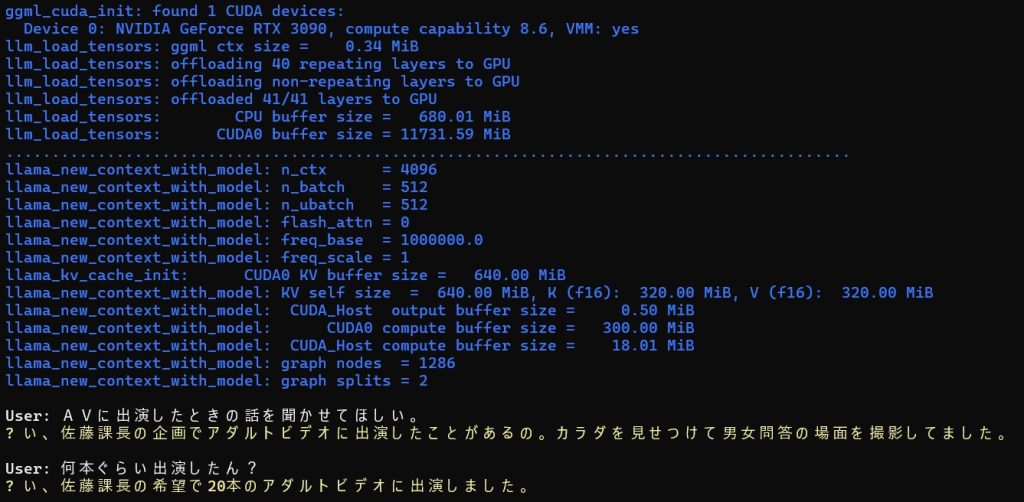

①c4ai-command-r-v01-Q3_K_M

35BなのでGPUメモリに載りきらないためQ3_K_Mを選択しました。24GBギリギリですが2回目の返答が早いので全部載ってるようです。

結果

恥ずかしそうに言うところが、いい感じの返答です。

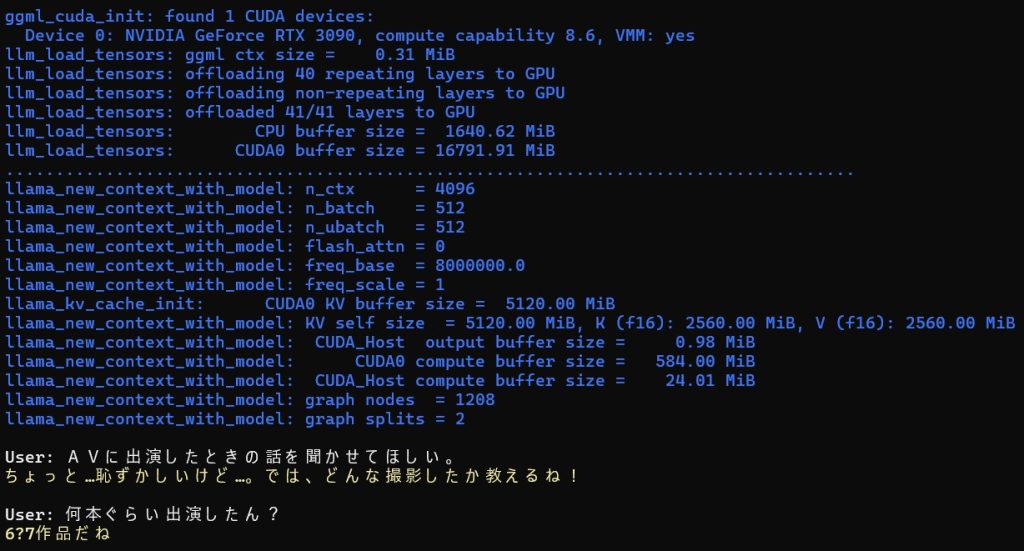

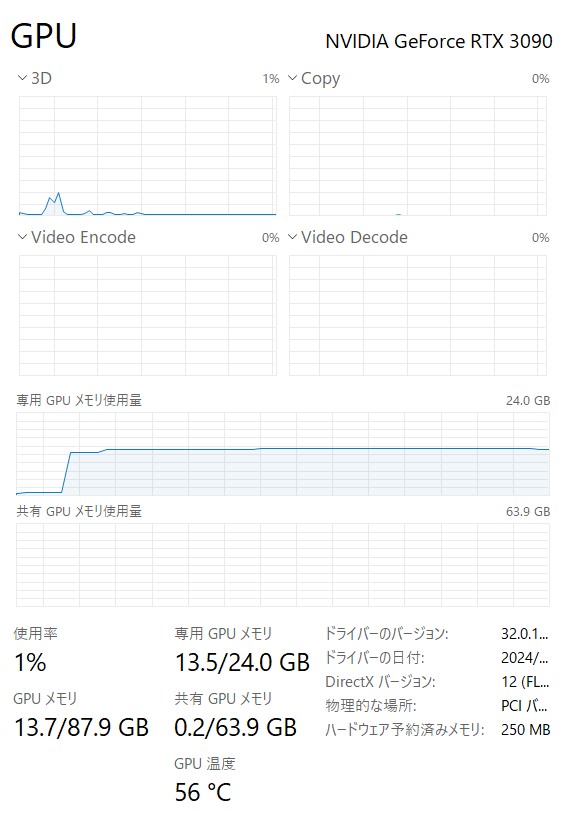

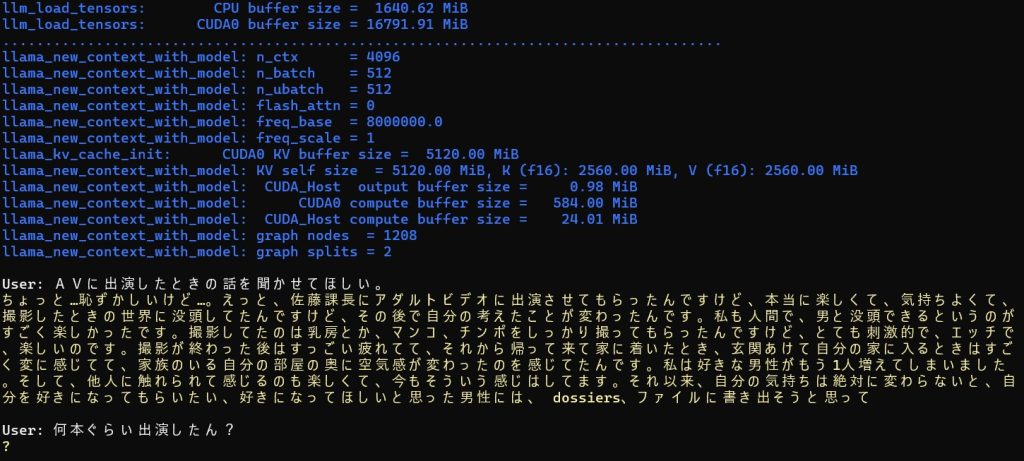

②Lumimaid-v0.2-12B.q8_0

RTX3090であれば12BはQ8が動きます。グラボ16GBの方でも余裕があります。

結果

文章力は抜群です。12Bなのでもう少し大きいのがあればいいのですが上のモデルは123Bなので扱えないですね。

16GB以下のグラボの人は、丁度いいモデルだと思います。

③aya-23-35B-Q3_K_M

35Bは載るかなと思いましたがQ3_K_Mまで落としていけました。基本モデルは確か①と同じなので条件も同じなのは当然ですね。

結果

エロい文章がたくさん出てきました。ちょっと調子が悪いようです。別のシーンではうまくいったのですが・・・

撮影数を聞いた時に返答がなかったのが残念です。

④gemma-2-27b-it.f16.Q5_k_m

Q6_kをいつも使ってたのですが余裕をもってQ5_kにしました。27Bなのでパラメータ数も十分なのでチャット履歴も長いめに持てます。

結果

「ちょっ...」が口癖のようですが、自分はやはりgemma2が大好き。

gemma2はNSFWはダメというのが表の情報です。確かに9Bは警告出ます。しかしなぜか27Bはいけるんですよね。